Kedves MTA Cloud felhasználók!

Az alábbi üzenetetet Mező György MTA Cloud felhasználónktól kaptuk a napokban, melyben személyes vélémenyét osztja meg az MTA Cloud használatával kapcsolatban. Örülünk, hogy az MTA Cloud hozzájárulhatott a projekt és a számítások sikerességéhez. További jó munkát kívánunk! (Az e-mailt változtatások nélkül közöljük.)

"Kedves Kollégák!

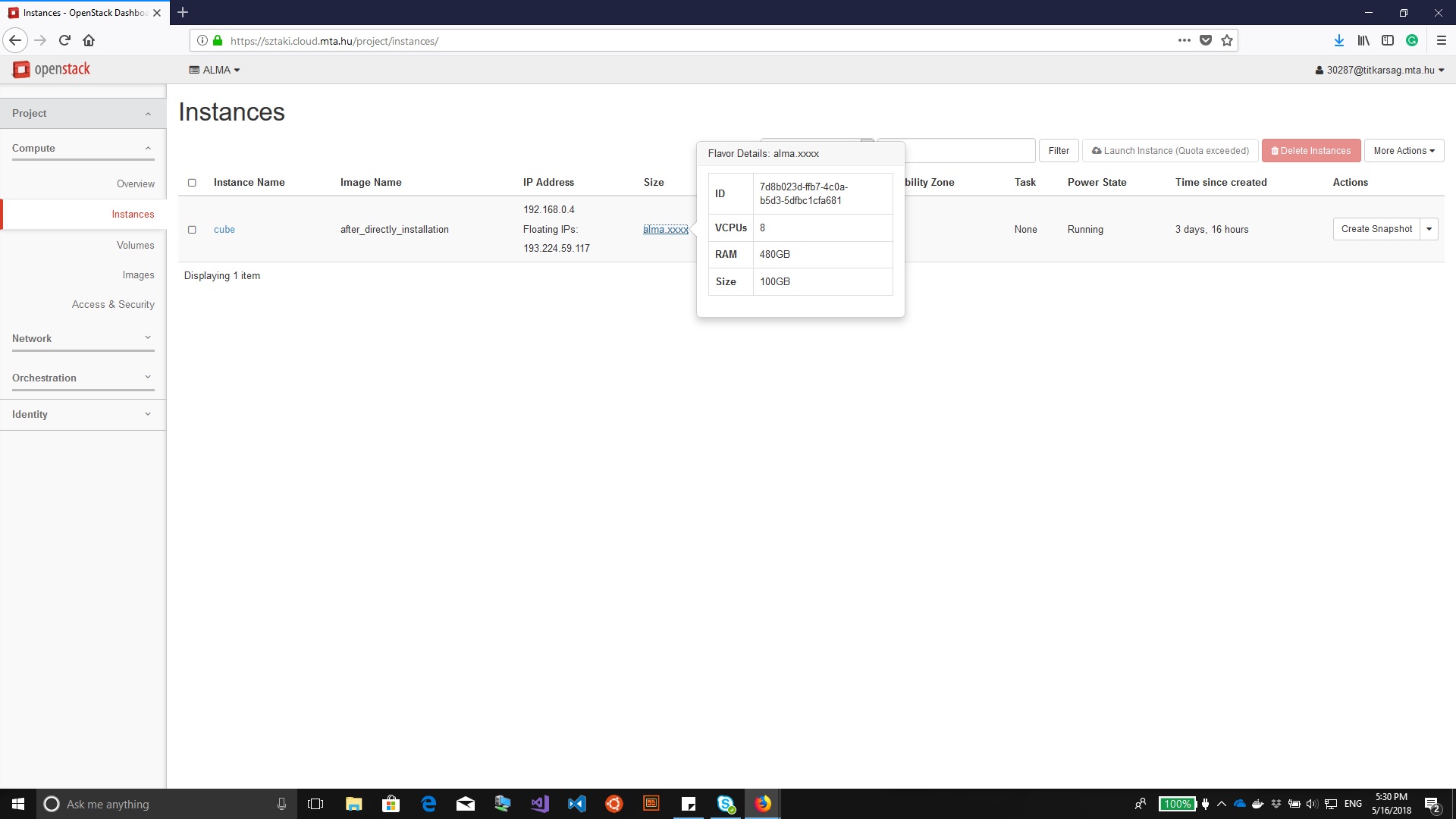

Köszönjük, hogy lehetőséget kaptunk arra, hogy egy 472 GB RAM-al

rendelkező külön nekünk létrehozott alma.xxxx flavor-u virtuális gépen

(nagy_alma_gep.jpg)

MTA SZTAKI CLOUD dolgozzunk. Azt is köszönjük, hogy megjelentek korábban

az alma-s flavor-ok.

Az ALMA rádió távcső sok antennából felépülő rádió interferométer

rendszer. Az adatok kiértékelésének utolsó lépése az az, hogy egy

"egyesített" távcsővel képet alkotunk a megfigyelt égi jelenségről. Maga

a létrehozott kép egy data cube. Esetünkben 3840 kép. 3840 különböző

hullámhosszon, spektrális csatornán készül kép. A spektrális csatorna a

3. dimenzió. Magukat a képeket különböző térbeli felbontással lehet

készíteni. Az a javasolt, hogy legaláb 5 pixeles felbontással

készüljenek. Az 1,3,5,7 pixeles felbontás azt jelenti, hogy a

megfigyelést végző radio beam-et 1,3,5,7 pixellel mintavételezzük. A

radió beam térbeli mérete, ill. a mintavételezése határozza meg a

készülő képek térbeli felbontását.

Elsőre egy 128 GB-os gépet kaptunk. Ezen le tudtuk futtatni az összes

3840 csatornára 1 pixeles feloldással a képalkotáshoz szükséges

programokat. Azonban már 3 pixeles felodásra sem volt elegendő a 128 GB.

Ekkor kaptuk meg a 472 GB-os gépet. Ezen mind 3, mind 5 pixelre

lefutottak számolásaink.

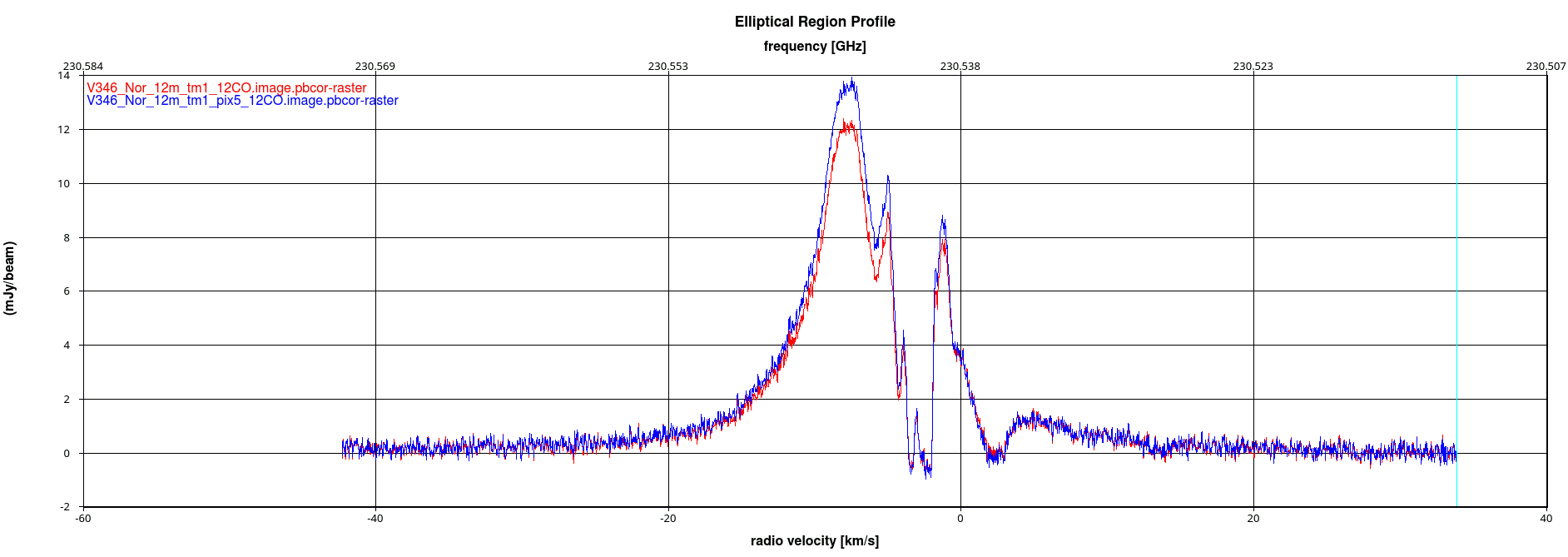

Csatolok két ábrát számolásainkkal kapcsolatban. Az első ábra a

3pix_vs_5pix_comparison a teljes spektrumon. Ez tényleg jól mutatja,

hogy -20 km/s és 0 km/s között 3 pixeles felodásnál kevesebb fluxust

látunk, mint 5 pixeles feloldásnál. Tehát fontos, hogy legalább 5

pixeles feloldású képeink legyenek. Az 5 pixeles feloldású kép

számolásánál 287 GB -t RAM-ot használtunk.

A 7 pixeles feloldású képet már nem tudtuk kiszámolni az összes

spketrális csatornára, mert ehhez már a 472 GB RAM sem volt elegendő.

Ekkor azt próbáltuk külföldi kollégáinkkal levelezgetve, hogy nem az

összes 3840 spektrális csatornára számolunk, hanem csak 500-ra. Azt a

részt számoltuk ki, aminél 3 és 5 pixeles feloldásnál eltérést láttunk.

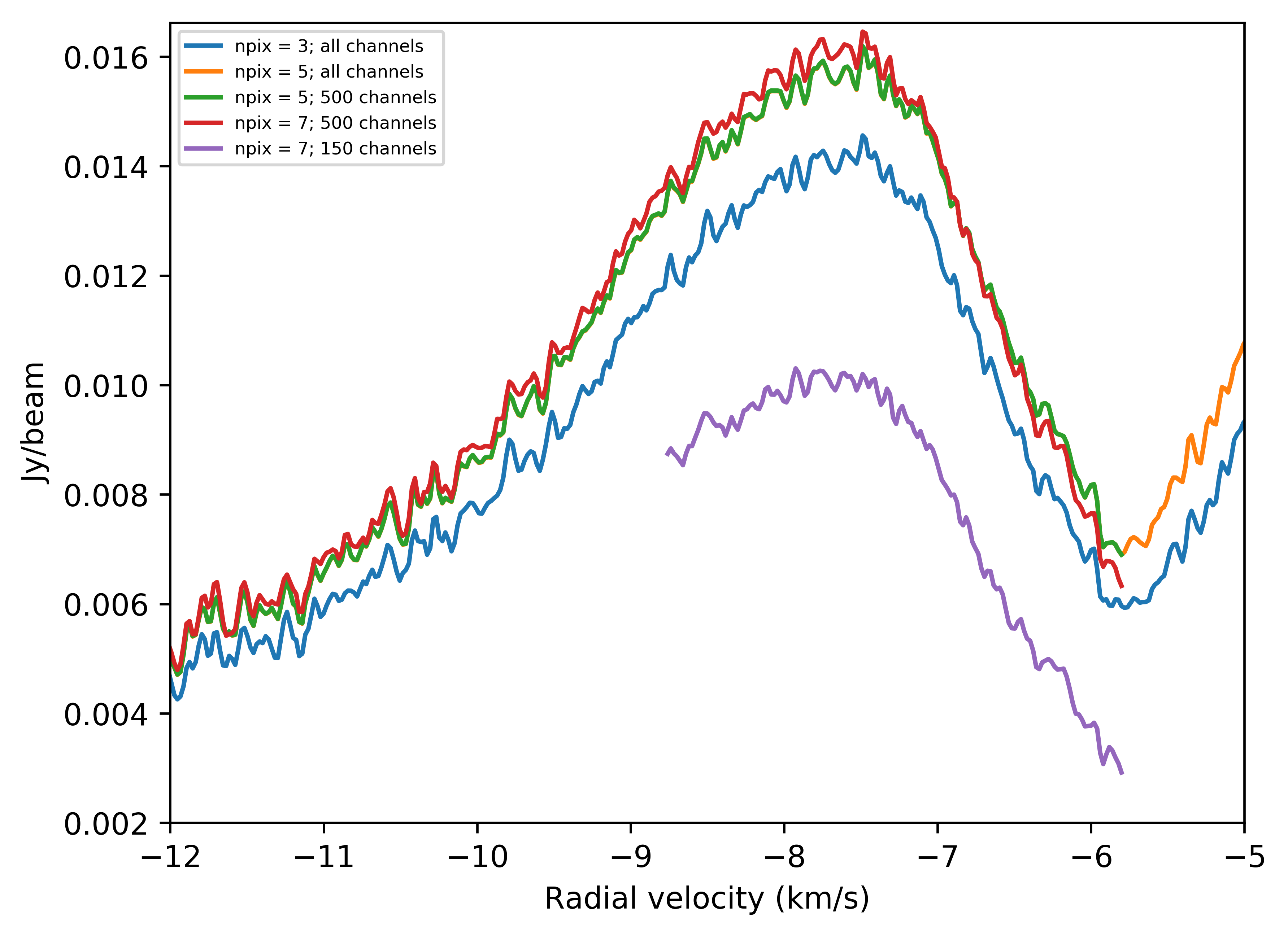

A 7 pixelre történt számolás (ez se ment volna kis xl-es gépeinken) a

profile.png képen mutatja hogy a narancs színű (5 pixeles) görbét nagyon

jól közelití a piros színű hét pixeles számolás. Az 5 pixeles 500

chaneles számolás (zöld) pedig teljes egyezésben van a narancsárga 5

pixeles feloldással teljes csatorna számra számolt narancs görbével.

Tehát lehet kimélni a RAM-ot az egyidőben számolt csatornák számának

csökkentésével. Így az OpenStack node-okra optimalizálni a számolást.

Ekkor jött a meglepetés, hogy a régi Wigneres felhőben 7 pixeles 150

(ennyi ment 32 GB RAM-al) csatorna számu számolás kevesebb fluxus-t

mutat a kiszámolt csatornákra, mint amit látnunk kellene.

Most itt tartunk. Rendelkezésünkre állnak azonban a nagy alma. xxxx

géppel számolt teljes csatorna számra vonatkozó eredmények. Ezek

segítségével megérthetjük, hogyan tudjuk optimalizálni a számolásainkat.

Láttuk azt is, hogy nem a scriptjeinkben van a hiba, hanem tényleg a

"kevés" RAM miatt kaptunk korábban hibaüzenetet a casa redukciós csomag

használata során.

Érdekes tapasztalás volt az is, hogy kutatóközpontunkban a legnagyobb

gépek 128 GB RAM-al rendelkeznek. Ha esetleg abban gondolkodunk, hogy

egy 256 GB RAM-os, vagy 512 GB RAM-os gépet vennénk, akkor teljesen

elvinné az informatikai büdzsénket, holott csak alkalmanként van

szükségünk ekkora gépre. Így nagyon jól jött az MTA CLOUD részéről a

segítség. Magának az öt pixeles felbontású összes csatornára számolt kép

(41 GB) kényelmes megjelenítéséhez (kiszúrni mi az érdekes rajta,és nem

csak részeket betöltve fejben összerakni a képet) is nagyobb gépre van

szükség. A KIFÜ HPC platformjához is hozzáférünk, de ott sem lenne

optimális ilyen számolásokat futatni.

Mégegyszer sok köszönet a segítségért!

Üdvözlettel:

Mező György"

Amennyiben Önnek is van hasonló sikerélménye, amit szívesen megosztana másokkal, kérjük írjon az info@cloud.mta.hu - címre!